Desde TEC consultamos a uno de sus fundadores y actual director ejecutivo, Francisco Morrone, quien contó en detalle las etapas del proceso desarrollado, destacando el componente innovador cuyo diferencial les permite procesar los materiales de manera selectiva y extraer los metales con alta pureza y en menor tiempo.

La innovadora startup argentina ALKEMIO propone descentralizar el mercado de refinación de metales críticos a través de una tecnología biomagnética modular, de bajo costo y altamente eficiente. El disruptivo proceso permite separar, recuperar y purificar elementos críticos, provenientes de diversas fuentes (como extracciones mineras o desechos electrónicos) para obtener metales de alta pureza para ser reutilizados en la producción de nuevas tecnologías clave para la transición económica.

Los cambios tecnológicos que permiten desarrollar nuevas formas de energía también abren la puerta a un mercado para los vehículos eléctricos y el desarrollo de tecnologías para el mejor aprovechamiento de esas energías. No obstante, el posible crecimiento exponencial traerá aparejados importantes desafíos como un notable aumento en la cantidad de residuos electrónicos -que se calcula alcanzarán las 75 millones de toneladas para 2030- y una escasez creciente en el suministro de minerales críticos.

Esto pone de relieve la importancia de encontrar soluciones innovadoras que promuevan el largo plazo de la industria, sobre todo porque los procesos hidrometalúrgicos utilizados actualmente resultan complejos y costosos; además de generar el doble de residuos por cada unidad de metal extraído.

Ante este escenario, tres científicos formados en universidades argentinas y con experiencia profesional en institutos del Consejo Nacional de Investigaciones Científicas y Técnicas (CONICET) y un emprendedor proveniente del mundo de los negocios fundaron ALKEMIO. Como misión se propusieron encontrar una solución innovadora que contribuya de manera sustentable y eficiente al procesamiento de metales clave para utilizar en nuevas tecnologías.

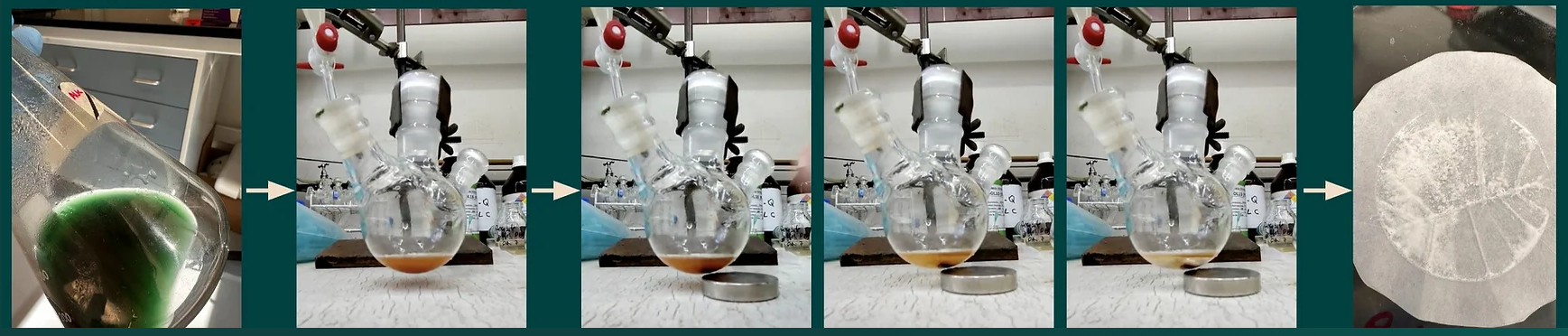

En diálogo con TEC, el cofundador y director ejecutivo de la empresa, Francisco Morrone, brindó más información sobre cómo consiguieron desarrollar un procedimiento pionero, disruptivo e innovador: “El proceso que creamos consta de tres etapas fundamentales. La primera de biolixiviación, en la que utilizamos una solución de ácidos orgánicos que nosotros mismos producimos a través de microorganismos, y en la que se diluyen los materiales a recuperar. Luego introducimos un complejo molecular que es capaz de unirse a los iones de los metales deseados para realizar, a continuación y por medio de magnetismo, una extracción selectiva, eficiente y rápida en menos de 30 minutos a escala industrial”, explicó Francisco y agregó que para la extracción selectiva se modifican las moléculas de acuerdo al material a procesar.

Respecto a otros insumos y al equipamiento necesario para llevar adelante el proceso, Morrone indicó: “Usamos reactores estándar y equipamiento off the shelf (salido del estante) que se encuentran disponibles para su obtención en cualquier parte del mundo y son económicos”.

Acerca de los metales, minerales y elementos críticos que se pueden recuperar implementando el proceso, el CEO de ALKEMIO contó que comenzaron “procesando y extrayendo el litio de baterías desechadas con alta eficiencia” y agregó que “actualmente estamos extrayendo y procesando materiales críticos como neodimio, disprosio y praseodimio, que son tierras raras que se utilizan para la producción de magnetos permanentes, un insumo clave para todo tipo de tecnología, por ejemplo, las turbinas eólicas utilizan más de 200 kg de estos elementos, los autos eléctricos los utilizan en sus motores, luces y pantallas de LCD”. “Tenemos como visión crear una tecnología de recuperación agnóstica de metales. Es decir, dependiendo del material tratado, recuperar cualquier tipo de metal que se encuentre en la solución. Y esto es posible por nuestro complejo molecular fácilmente adaptable a la captura del metal a extraer”, completó Francisco.

Morrone relató que están trabajando con dos grandes mineras de Brasil y de Chile que les envían muestras de tierras raras para su extracción eficiente a través del proceso y aclaró que “hoy en día los volúmenes son muy chicos. Estamos trabajando a escala de laboratorio manejando gramos pero la idea es terminar a fin de año o empezar el año que viene a procesar kilos para poder enviarle muestras a nuestros potenciales clientes”.

Uno de los desafíos técnicos más importante que enfrentaron en el desarrollo del proceso fue la manipulación de los complejos moleculares: “Tuvimos algunos percances como contaminación de muestras que hacían que obtengamos resultados negativos, hasta que le encontramos la vuelta y comenzamos a encontrar los resultados que buscábamos” explicó Francisco y agregó que también sufrieron impedimentos y dilaciones en la importación de reactivos y otros insumos menores específicos necesarios para las instancias de investigación.

COFUNDADORES Y EQUIPO CIENTÍFICO

Lucía Curti es cofundadora y la directora científica (CSO) de ALKEMIO.

Comenzó estudiando licenciatura en Genética en la Universidad Nacional del Noroeste de la Provincia de Buenos Aires (UNNOBA) y fue tesista de grado en el Instituto Universitario «Escuela de Medicina» del Hospital Italiano de Buenos Aires. También se desempeñó como becaria doctoral del CONICET en el Instituto de Medicina Traslacional e Ingeniería Biomédica y fue estudiante de doctorado en la Universidad Nacional de Quilmes. Es experta en biología molecular, biotecnología, desarrollo de ensayos, diagnóstico molecular y gestión de proyectos.

Federico Pereyra-Bonnet es cofundador y director de información (CIO) en la compañía.

Es licenciado en Ciencias Biológicas y Doctor de la Universidad de Buenos Aires (UBA). Durante su carrera se especializó en biología del desarrollo, biotecnología reproductiva y biomedicina humana. Fue investigador del CONICET en el área de Tecnología y Proyectos Complejos. Realizó un postdoctorado en células madre en el Hospital Italiano de Buenos Aires y fue miembro del Consejo de Investigación del Instituto Universitario-Hospital Italiano de Buenos Aires y de la Comisión Asesora de Medicina Regenerativa y Terapias Celulares del ex Ministerio de Ciencia, Tecnología e Innovación Productiva de la nación.

Ailín Svagzdys es cofundadora y directora de investigación (CRO) en ALKEMIO. Es licenciada en biotecnología de la Universidad Argentina de la Empresa (UADE). Fue estudiante de pregrado en el Instituto de Investigaciones en Ingeniería Genética y Biología Molecular del CONICET. En la empresa es responsable de liderar el equipo de microbiología y explorar nuevas iniciativas de investigación y desarrollo en la búsqueda de enfoques innovadores para mejorar el proceso.

El equipo científico se completa con la Dra. Lorena Molina Calderón, líder del departamento de química; la Dra. María Lucía Burdisso, experta en microbiología; y la licenciada Maira Bianchini y el Dr. Andrés Charris-Molina, ambos expertos en química.

.

El espacio que demanda el montaje del equipamiento para realizar el proceso representa un cuarto del espacio que ocupan las plantas de recuperación de metales que se utilizan en hidrometalurgia, el sistema tradicional más extendido en la actualidad. “La selectividad, la eficiencia y la velocidad que logramos con nuestro proceso nos permite utilizar menos etapas para obtener y recuperar la misma cantidad de metales, reduciendo en tres cuartos el espacio que demandan las instalaciones para hidrometalurgia”, precisó Francisco y ejemplificó: “Para que tengan una dimensión, una planta de hidrometalurgia mide lo mismo que una cancha de fútbol y el espacio que demandaría la instalación de una planta para llevar adelante nuestro proceso ocuparía hasta la línea externa del semicírculo del área grande”. Luego agregó: “Estas dimensiones facilitan la colocalización de nuestra planta en el mismo lugar donde se encuentran los materiales a recuperar, lo que permitiría reducir los aspectos logísticos no solo por los costos sino también por el ahorro en emisiones de gases de efecto invernadero que emite el transporte”.

El compromiso de ALKEMIO con la sustentabilidad ambiental se ve plasmado en todas las instancias de su proceso “cuyo componente de innovación es total” reflexionó Morrone. “Más del 90% del procesamiento de tierras raras se realiza en China utilizando la hidrometalurgia. Esto implica la utilización de grandes cantidades de ácidos altamente contaminantes, como el sulfúrico, el nítrico y otros solventes peligrosos, y la aplicación de temperatura para las etapas de lixiviación y precipitación de los metales, lo que conlleva la emisión de gases durante el proceso y la obtención de residuos contaminantes y peligrosos al finalizarlo” aclaró Francisco. “Para lograr un proceso amigable con el ambiente reemplazamos la utilización de todos los ácidos contaminantes por una química verde a través del proceso de biolixiviación, en el que utilizamos los ácidos orgánicos y en el proceso de extracción donde aplicamos nuestros complejos moleculares”, aseguró.

En cuanto a los inicios de la startup, Francisco comentó que el primer impulso que recibieron fue a través de un apoyo financiero por parte de GRIDX, un fondo de inversión orientado a incubar empresas de base científico tecnológica: “Esa inversión inicial nos permitió empezar a desarrollar las primeras pruebas de concepto y contratar los primeros empleados”, y completó: “Actualmente estamos participando de un programa de la aceleradora de la Universidad de Berkeley en San Francisco (Estados Unidos) donde también obtuvimos financiamiento y nos están acompañando a acelerar el proceso de go to market, modelo de negocios y colaboraciones o partnerships. Esto nos va a permitir poder llegar a nuestro próximo milestone (hito) que sería desarrollar nuestro prototipo para poder comenzar a enviar muestras a potenciales clientes, y nos ayudará a prepararnos para la presentación ante nuevos inversores en una ronda que planeamos abrir el próximo mes de agosto”.

Asimismo, Morrone destacó: “Estamos buscando establecer colaboraciones con empresas interesadas en desarrollar pilotos o pruebas con nuestra tecnología”, y agregó también que constantemente buscan “perfiles científicos para sumar al equipo”. Además, se mostró dispuesto a explorar posibles acuerdos de cooperación en I+D (investigación y desarrollo) con el CONICET, para poder trabajar con grupos de investigación específicos que puedan contribuir con sus capacidades e investigaciones a la mejora constante y la aceleración de los procesos de la compañía.

Más información sobre ALKEMIO

La compañía, fundada a principios de 2023, posee un sitio web accesible en https://www.alkemio.bio. También tienen presencia en redes sociales, en Instagram como @alkemio.bio y en Linkedin como ALKEMIO.